Florian Lang und Tonja Machulla haben eine Studie zur Augmentierung von Touchscreens publiziert. Der (englische) Artikel ist hier frei verfügbar.

In der Studie wurden unterschiedliche Augmentierungen für einen Touchscreen untersucht. Dabei wird mithilfe einer Datenbrille für erweiterte Realität eine Zielhilfe eingeblendet, die es auch Menschen mit starker Sehbeeinträchtigung ermöglichen soll die gewünschte Taste schnell und sicher zu drücken.

Hier sehen wir das verschwommene Bild eine Fahrkartenautomaten und große blaue Linien, welche sich über der zu drückenden Taste kreuzen.

Die Studie hat gezeigt, dass diese Zielhilfen Menschen mit niedrigem Restsehvermögen eine vorher unmögliche Interaktion mit dem Touchscreen erlauben. Für Menschen mit höherem Restsehvermögen, denen bereits eine Interaktion mit dem Gerät möglich war, wurde der benötigte Aufwand und die benötigte Zeit verringert. Die Resultate zeigen also, dass Augmentierungen durch eine Datenbrille Menschen mit Sehbeeinträchtigung im Alltag unterstützen können.

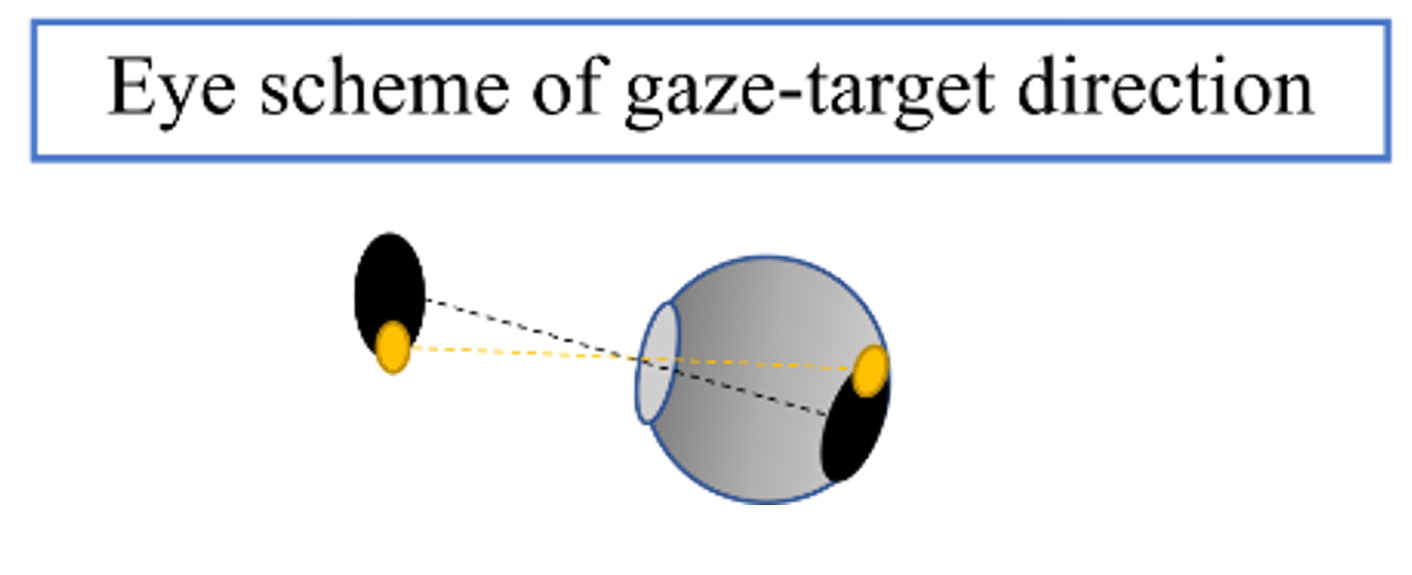

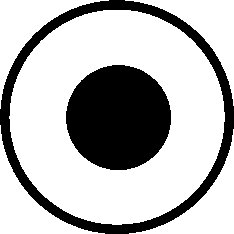

Auf der linken Seite sehen wir eine schematische Darstellung der Augmentierung und auf der rechten Seite die Blickrichtung des Auges, sowie das Skotom in schwarz und das Ziel in gelb, jeweils inkl. der dazugehörigen Position auf der Netzhaut.

In der Studie wurde eine periphere Augmentierung untersucht, welche entwickelt wurde um einen neuem Fokuspunkt im peripheren Gesichtsfeld (PRL) zu trainieren. Dabei wurde der Effekt sowohl vor als auch nach der Simulation des Skotoms untersucht. Die Augmentierung bestand aus einem Ring um das simulierte Skotom (siehe Foto, links). Vor Anzeigen des Skotoms hat die Augmentierung das Blickverhalten positiv beeinflusst. Das antrainierte positive Blickverhalten wurde anschließend auch ohne Einblendung einer Augmentierung beibehalten.

Die Augen richten sich direkt auf den neuen Fixationspunkt, sodass sich das Ziel (in gelb, siehe Foto, rechts) außerhalb des simulierten Skotoms befand und daher sichtbar war. Die Resultate deuten auf eine Möglichkeit zum frühen Training von periphere Fokussierung hin.

Alexandra Sipatchin, Siegfried Wahl und Katharina Rifai haben eine Studie zur Nutzung der HTC Vive Pro Eye für klinische Augenuntersuchungen publiziert. Das (englische) PDF ist hier frei verfügbar.

Die Veröffentlichung untersucht die aktuelle Nutzbarkeit von Eye-trackern in komerziellen VR-Headsets für medizinische Augenuntersuchungen. Die Genauigkeit der Daten wurde über das gesamte Anzeigefeld des Headsets überprüft um festzustellen ob das Headset von Patienten Zuhause für visuelle Untersuchungen eingesetzt werden kann. Mit Hilfe eines kleinen Computers wurde eine Latenz, also eine Verzögerung in den Daten, in Höhe von 58ms festgestellt. Dies bedeutet, dass das Headset vielversprechend für den Einsatz in kommerziellen Assistenzsystemen für Menschen mit Sehbeeinträchtigung ist.

Florian Lang, Tonja Machulla und Albrecht Schmidt haben unterschiedliche Repräsentationsformen für Information in sogenannten Datenbrillen untersucht. Das (englische) PDF ist hier frei verfügbar.

In der Arbeit werden an zwei Anwendungsbeispielen unterschiedliche Repräsentationsformen für Information untersucht. Zum einen eine aplhanumerische Repräsentation in Zahlen und Buchstaben und zum anderen eine symbolische Repräsentation durch abstrakte Symbole.

Abbildung 1 aus der Veröffentlichung zeigt alternative Repräsentationsformen für die Emotionen eines Gesprächspartners und die Uhrzeit.

Die Evaluierung der Augmentierungen mit Menschen mit Sehbeeinträchtigung hat gezeigt, dass Menschen mit unterschiedlichen Sehstärken unterschiedliche Repräsentationsformen bevorzugen. Während einfache und abstrake Formen von allen Teilnehmern gleich gut wahrgenommen werden konnten, waren komplexe Symbole oder alphanumerische Repräsentaionen nicht für Menschen mit sehr geringem Visus geeignet.

Eine deutsche Zusammenfassung der Arbeit hat der Schweizerische Blinden- und Sehbehindertenverband auf seiner Hompage veröffentlicht.

Die Uni Kassel hat im Auftrag des IZEW ein Rechtsgutachten erstellt. Dieses behandelt datenschutz- und haftungsrechtliche Fragen, welche sich aus der Nutzung von augmentierter und virtueller Realität im Alltag ergeben. Das Rechtsgutachten behandelt außerdem die sogenannten Living-Labs. Ein weiteres Projekt des BMBF, welches sich ebenfalls mit dem Einsatz von AR und VR für Gesundheit und Wohlbefinden beschäftigt.

Wir stellen das Dokument hier zur freien Verfügung.

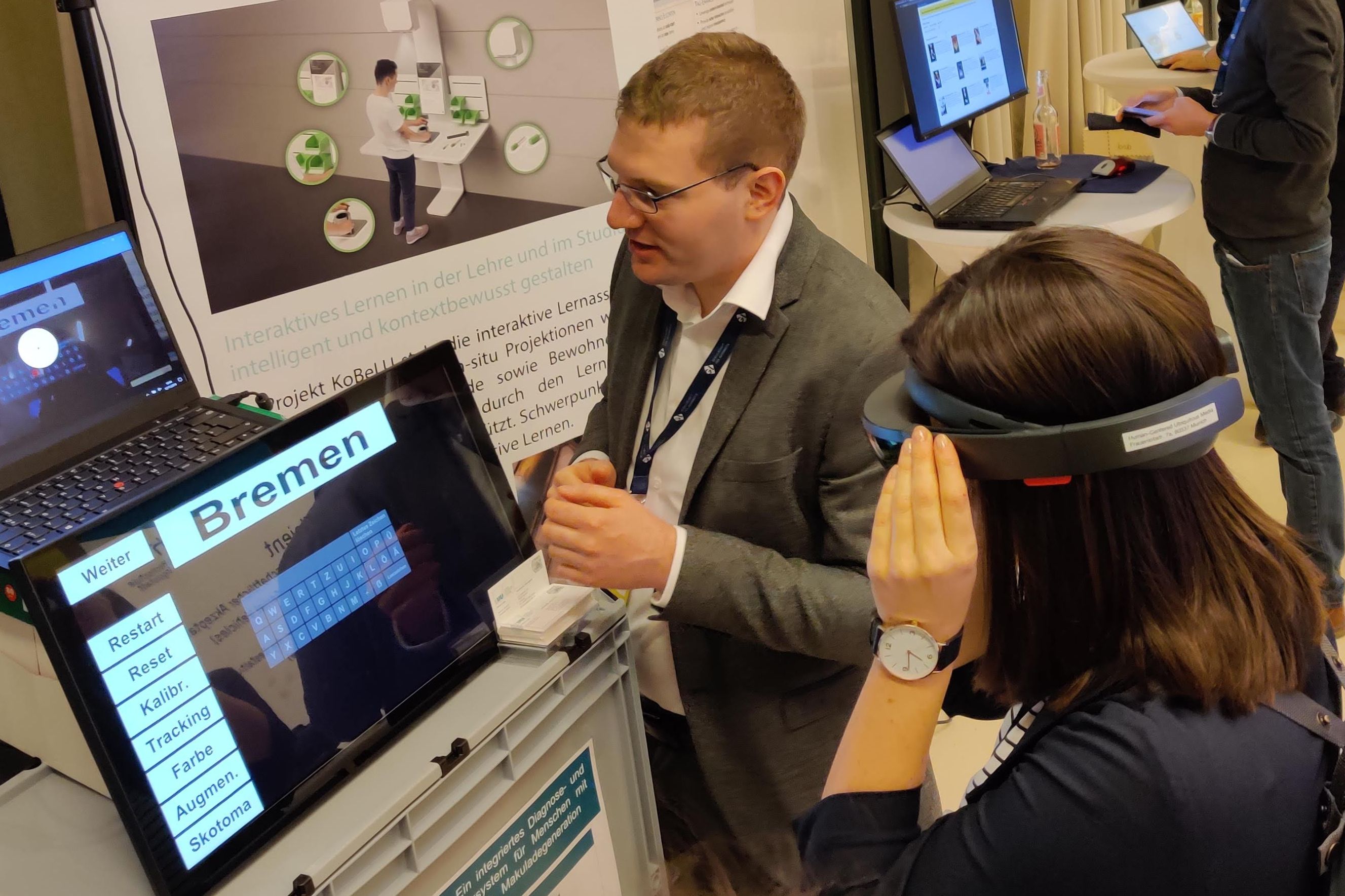

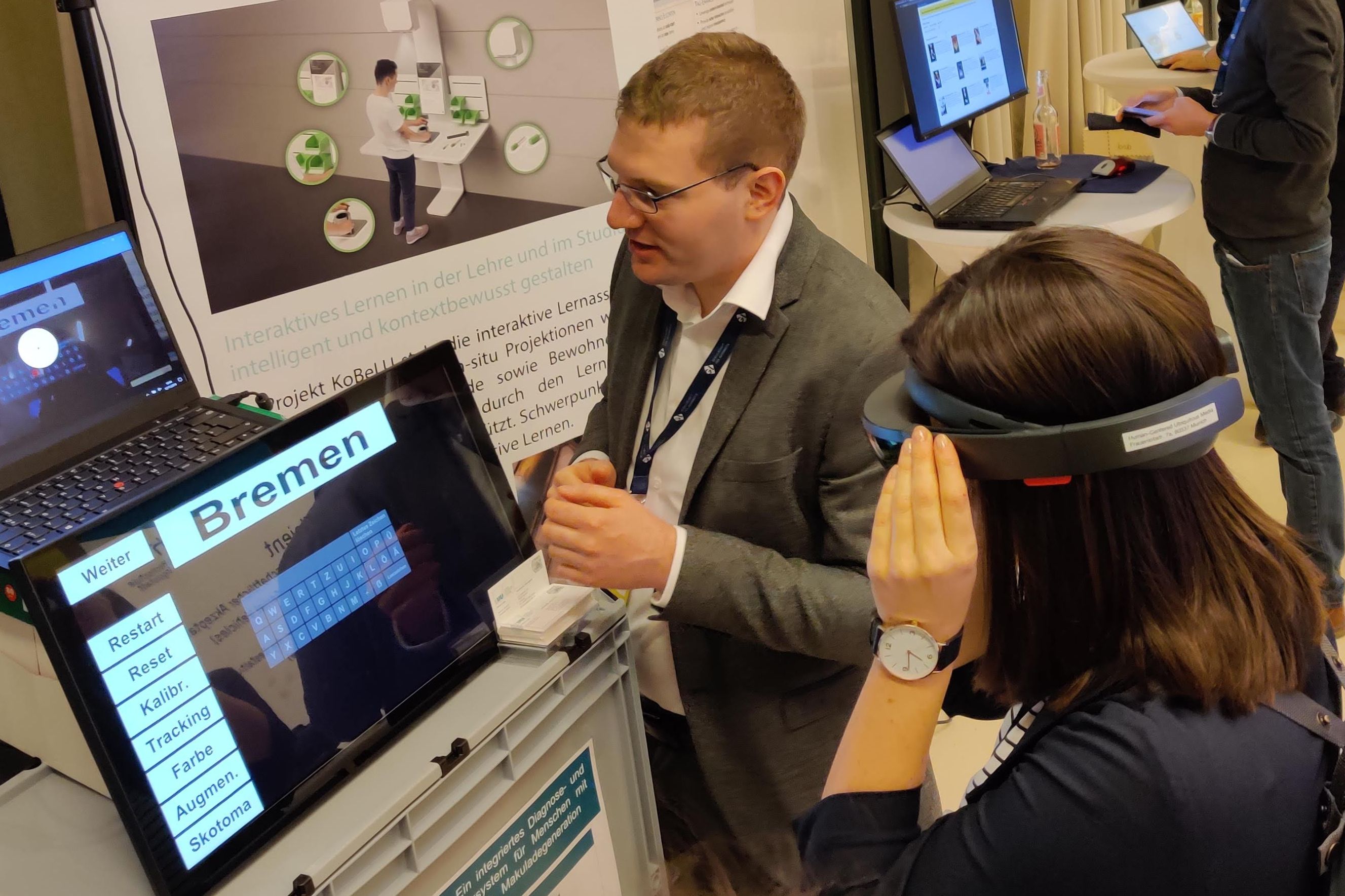

Der Fachbereich Mensch-Computer-Interaktion der Gesellschaft für Informatik hat am 12.11.2019 in Berlin ein Symposium KI für den Menschen veranstaltet. Neben einer interessanten Panel-Diskussion zum Thema "KI mit den Menschen – KI für die Menschen" an welcher Prof. Albrecht Schmidt sich beteiligte, haben wir auch einen Demonstrator für eine Assistenzfunktion vorgestellt.

Foto: Thomas Kosch

Der vorgestellte Funktionsdemonstrator ermöglicht Personen mit Zentralskotom eine einfache Bedienung von Touchscreen Interfaces. Dabei wird eine Datenbrille verwendet um das aktuelle Ziel, also den zu drückenden Knopf, hervorzuheben bzw. das Auffinden zu erleichtern. Weiterhin war für die Besucher eine rudimentäre Simulation eines Zentralskotoms eingebaut um das Verständnis für Betroffene zu erhöhen und die Schwierigkeiten im Alltag anderen klar zu machen.